Paula Pueyo, psicóloga: “Volcar tus conflictos emocionales en ChatGPT no es terapia ni puede sustituir la mirada empática de un terapeuta”

Tecnologías emergentes

Crece el uso de inteligencias artificiales como espacio de desahogo emocional, pero apoyarse en ellas como si fueran terapia puede tener consecuencias peligrosas

¿La IA te va a quitar el trabajo? Estos son los empleos más amenazados por la inteligencia artificial, según una lista oficial que ha publicado Microsoft

Las IA pueden servir para informarse sobre bienestar o ansiedad, pero no para tomar decisiones emocionales complejas

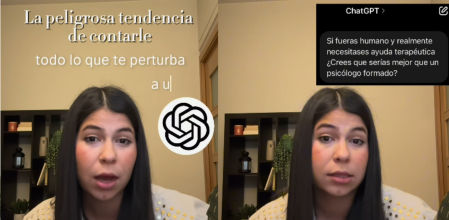

ChatGPT no es tu terapeuta. Aunque pueda ofrecerte pautas sobre respiración o darte información sobre el estrés, jamás podrá escucharte con empatía real ni comprender tu historia vital. Así lo plantea Paula Pueyo, psicóloga, en un vídeo reciente en su cuenta de Instagram (@paulapueyo_psicologia), donde reflexiona sobre lo fácil que se ha vuelto utilizar la inteligencia artificial como lugar de desahogo emocional, cuando en realidad lo que necesitamos es ser escuchados por alguien humano.

“Cada vez más personas están volcándole sus conflictos emocionales a ChatGPT como si fuera un terapeuta”, advierte. Pero no lo es. Y según Pueyo, esta tendencia no solo está en redes: también la observa en su propia consulta.

La psicóloga reconoce que hay usos útiles y válidos para este tipo de herramientas: “Sería adecuado, por ejemplo, si queremos obtener una batería de herramientas de respiración, psicoeducación sobre determinados conceptos como puede ser la ansiedad, el estrés, rutinas de bienestar o de prevención”. En este sentido, una IA puede actuar como complemento o recurso puntual.

Pero insiste en marcar la línea roja: “Cuidado, psicoeducación sí, autodiagnóstico no”. Porque cuando se trata de decisiones emocionales profundas —como volver o no con una expareja, o interpretar la conducta de otra persona—, delegar esas preguntas a un robot puede volverse peligroso.

No va a entender quién eres”

Pueyo lo explica con un ejemplo que realizó en primera persona: consultó a ChatGPT sobre si sería mejor que un psicólogo formado en caso de una crisis emocional. “Me da la siguiente respuesta, concluyendo que puede ser un buen recurso complementario o un espacio de reflexión, pero que si se encontrase realmente en una crisis real recurriría a un terapeuta de carne y hueso”, relata.

Y es ahí donde pone el foco: en lo humano, lo real. “Jamás tendrá la habilidad y la calidad humana que tiene una persona que conoce ya no sólo tu conducta porque la haya analizado en profundidad, sino tu historia vital, tus aprendizajes, tus patrones relacionales y te entiende de una forma real e integral”.

Una IA no puede mirarte a los ojos. No puede interpretar tus silencios. No puede ver el contexto completo desde donde hablas o callas. “Un psicólogo te mira, te escucha y te entiende de forma integral. Y ChatGPT no puede hacer eso”, sentencia.

Complemento, sí. Sustituto, nunca

Cuando el algoritmo no basta para sana

Por eso, el mensaje de Pueyo no es demonizar el uso de herramientas como ChatGPT, sino dejar claro para qué sí y para qué no. “Úsalo como complemento pero no como sustituto a una terapia real”, resume.

Buscar herramientas está bien. Informarse también. Pero “no delegues tu salud emocional en una máquina”. Porque la salud mental no se automatiza. Y cuando hay dolor profundo, cuando las heridas piden ser vistas de verdad, no hay inteligencia artificial que pueda sustituir la presencia cálida de alguien que te escucha, te contiene y te acompaña.