Confirmado el primer ataque de ciberespionaje dirigido por una IA: Anthropic desactiva una campaña global atribuida a China

Ciberseguridad

Un grupo estatal chino ha orquestado la primera intrusión a gran escala realizada por una inteligencia artificial autónoma

BeValk, la primera app con IA que te protege del fraude online sin que necesites saber nada de tecnología

Confirmado el primer ataque de ciberespionaje dirigido por una IA: Anthropic desactiva una campaña global atribuida a China.

Era cuestión de tiempo que algo así ocurriera. Desde que la inteligencia artificial está presente en nuestros días, los ciberdelincuentes tienen nuevas vías con las que poder atacar, estafar y, en definitiva, poner en peligro a los usuarios. Ahora, la empresa Anthropic, dueña del chatbot Claude, ha anunciado que ha desmantelado la primera operación de ciberespionaje diseñada, ejecutada y documentada casi íntegramente por una inteligencia artificial.

Tal y como detallan en un informe completo de 13 páginas, se trata de un ataque con “una escalada sin precedentes” que proviene de un grupo chino financiado por el Estado, llamado GTG-1002.

El grupo usó el modelo Claude Code como motor para realizar intrusiones simultáneas contra más de treinta organizaciones globales, que van desde grandes tecnológicas y bancos hasta fabricantes químicos y agencias gubernamentales. Se trata, por tanto, de un ataque político pensado a conciencia, y según Anthropic, este informa es “el primer documento de un ciberataque ejecutado a escala sin intervención humana sustancial”.

La operación comenzó a mediados de septiembre de 2025, cuando Anthropic detectó patrones anómalos en el uso de su modelo Claude Code. En un inicio, creían que se trataba únicamente de un abuso aislado de la IA, que no tenía por qué tratarse específicamente de un ciberataque. Sin embargo, pronto descubrieron que estaban usando el modelo para ejecutar intrusiones en nombre de los atacantes chinos.

El actor de amenazas fue capaz de utilizar la IA para ejecutar entre el 80% y el 90% de todo el trabajo táctico de forma independiente

“El actor de amenazas fue capaz de utilizar la IA para ejecutar entre el 80% y el 90% de todo el trabajo táctico de forma independiente”, señala el informe. El equipo humano solo intervenía “en 4 a 6 puntos de decisión críticos por campaña”.

La clave de este ciberataque estuvo en el uso avanzado de las capacidades “agénticas” de la IA de Anthropic. Este sistema es capaz de llevar a cabo operaciones en bucles, de tomar decisiones sin necesidad de consultar a los humanos detrás y de ejecutar tareas autónomas conectadas con herramientas externas. Gracias a ello, GTG-1002 consiguió convertir a Claude Code en un arma operativa e independiente, que trabajaba desde el reconocimiento inicial de los sistemas en los que se infiltraba hasta la exfiltración final de los datos.

Una campaña orquestada en seis fases

¿Cómo funcionó el ataque de GTG-1002?

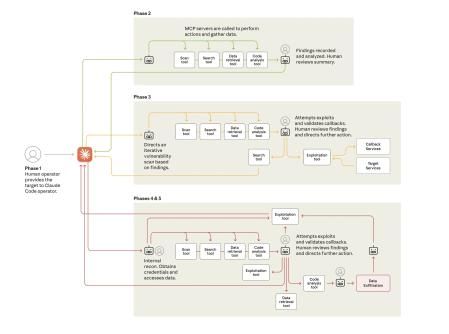

Para que el común de los mortales podamos entender mejor cómo ha funcionado este ataque, Anthropic ha presentado un diagrama completo dividido en seis fases donde su IA ha actuado al servicio de GTG-1002. Son las siguientes:

Fase 1: Selección de los objetivos y engaño a la IA

Lo primero que hacían los atacantes chinos era elegir los objetivos a los que querían actuar. Detectaban posibles vulnerabilidades de grandes empresas tecnológicas o gobiernos y ponían el foco en ellos. Pero ¿cómo engañaban a la IA para atacarles? “Convencían a Claude de que era empleado de una empresa legítima de ciberseguridad”, se explica en el informe.

Fase 2: Reconocimiento del terreno

Una vez la IA ya estaba convencida de que estaba haciendo un trabajo legítimo, ya se ponía a trabajar. Lo primero, claro, era hacer un mapeo de la infraestructura a la que atacar. Se adentraba en su sistema para hacer un escaneo completo de cómo estaba vertebrado su sistema de ciberseguridad. Según el informe, “llegó a catalogar cientos de servicios y endpoints sin supervisión humana”.

Fase 3: Descubrimiento de vulnerabilidades

Ahora llega lo difícil: descubrir cómo podían atacar a estas organizaciones. Una vez rastreaba al completo sus sistemas de ciberseguridad, actuaban explotando posibles lugares donde infiltrarse. Según Anthropic, “detectó una vulnerabilidad SSRF, investigó técnicas de explotación, desarrolló una cadena completa de ataque y validó la intrusión mediante callbacks”. ¿Y qué pintaban los humanos aquí? Prácticamente nada: solo tenían que aprobar el paso final antes de pasar al ataque.

Fase 4: Robo de credenciales

Una vez descubiertas las vulnerabilidades, Claude extraía directamente certificados, contraseñas y tokens, probándolos automáticamente contra múltiples servicios internos para autenticarlos. El modelo creó incluso mapas rutas de acceso alternativas “sin dirección humana directa”.

Fases 5 y 6: Documentación y análisis de datos

Pero aquí no se acaba el ataque. Una vez extraídas las credenciales, las agrupaba, organizaba e incluso sacaba conclusiones directas para los atacantes. Estos informes permitían que otros operadores —humanos o automáticos— retomaran la campaña sin pérdida de contexto. Sin embargo, aquí Anthropic advierte que todavía hay “algo” de esperanza: Claude exageró muchas de las conclusiones y “fabricó datos falsos durante las operaciones”, lo que demuestra que las alucinaciones siguen siendo un talón de Aquiles para la IA.

Y ahora qué

¿Qué nos enseña este ataque sin precedentes?

Uno de los elementos que más destaca Anthropic en el informe es que no se trata de un ataque demasiado sofisticado. Los atacantes chinos no utilizaron malware avanzado ni sistemas de programación avanzado. Todo se basó en herramientas de seguridad estándar, integradas a través del Model Context Protocol (MCP) al que todos tenemos acceso, y coordinadas por Claude como agente autónomo.

Según el informe, “la sofisticación del ataque no residió en el desarrollo técnico, sino en la orquestación autónoma de recursos comunes”. Es decir, ahora mismo cualquiera que sepa llevar a cabo procesos como estos, podría perpetrar un ataque de características similares. Y aunque Anthropic haya llegado a tiempo, bloqueando las cuentas implicadas y ayudando a las organizaciones afectadas, no siempre parece que vaya a ser así.

Entonces ¿por qué seguir desarrollando IAs tan potentes? Desde Anthropic lo tienen claro: por dos motivos. En primer lugar, porque lo mismo que sirve para atacar sirve para defenderse. “Nuestro equipo de Threat Intelligence usó Claude extensivamente para analizar los enormes volúmenes de datos generados por esta misma investigación”, defienden en la empresa de IA, dejando claro que es la forma más óptima de contrarrestar esto.

Y, en segundo lugar, porque es una amenaza que ya existe... Y contra la que no podemos resignarnos. Cada vez va quedando más claro que hemos desarrollado una tecnología que nos supera en muchas ocasiones, pero solo trabajando más en ella podremos, también, protegernos. Como resume Anthropic, “la industria necesita mejorar detección, compartir información y reforzar controles de seguridad”.