Para casi todo el mundo, la marca Google se identifica con el buscador Google, lo que tiene todo el sentido: así nació la compañía que hoy domina el 90% de las búsquedas en internet y estas le proporcionan el 56% de los ingresos a través de la publicidad. Pero el mayor de sus negocios no goza de tanto crecimiento como su división Google Cloud, que el año pasado habrá triplicado la facturación del 2022. Es fácil colegir que los servicios afines a la inteligencia artificial explican una aceleración tal que probablemente se prolongará en el 2026: el valor de las órdenes de pedido no contabilizadas alcanzaba a finales de septiembre los 155.000 millones de dólares, un 86% en doce meses.

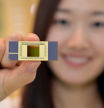

La inercia del mercado indica que el aumento del gasto en computación en la nube se agudiza gracias a la IA generativa y confirma que Google Cloud está en una posición de privilegio para satisfacer ese apetito: su nueva generación de chips aceleradores TPU es una pieza central para equipar centros de datos propios y ajenos y con ello ganar cuota del negocio que coloquialmente se conoce como “la nube”. Es verdad que AWS (Amazon) y Azure (Microsoft) facturan el doble que Google Cloud, pero su ritmo de crecimiento es inferior.

En la omnipresente IA, la inferencia va ganando terreno al aprendizaje de modelos

Quede claro que la suma de estos tres representa el 62% de un mercado mundial que la IA va expandiendo en dos direcciones: una, más allá del entrenamiento de los modelos y algoritmos, cuando hay que pasar de la experimentación a la ejecución de aplicaciones de tiempo real, surge la necesidad de equiparse para la inferencia, y dos, los apagones sufridos últimamente por las nubes de Amazon y Microsoft han acentuado el viejo reclamo de capacidades para migrar entre nubes que hasta ahora se las han arreglado para evitarlo.

Cuando se habla de IA, esta es una simplificación. La consultora McKinsey sostiene que la excepcional demanda de infraestructura se debe cada vez más a la inferencia (capacidad de extrapolar conclusiones a partir de los datos de un modelo previamente entrenado) que al entrenamiento masivo. Y pronostica que, en el 2030, la inferencia representará hasta el 40% de las cargas en los centros de datos que hoy se construyen con cuantiosas inversiones.

Algunos proveedores de servicios cloud han desarrollado chips propios que, de paso, aminoran su dependencia con respecto a la omnipresente Nvidia. Amazon tiene su Trainium y Microsoft está tardando, pero Google ya va por la séptima generación de sus aceleradores TPU y acaba de anunciar un acuerdo para suministrar a los centros de datos de Meta medio millón de unidades antes del 2027. Estos chips sirven para tareas específicas y –esto dice la compañía–, al ser más eficientes, ayudarían en la contención de costes de cada carga de IA, disparados por el consumo de energía, hoy el gran cuello de botella.

Contar con sus propios chips aceleradores reduce la dependencia respecto de Nvidia

En cuanto a la segunda cuestión, Google Cloud ha suscrito otro acuerdo con su rival AWS: ambos pretenden lanzar en común un servicio multinube diseñado para que, ante una interrupción accidental del servicio, los clientes de uno puedan migrar un proceso crítico al otro, mediante una conexión de banda muy ancha y de tal modo restablecerlo en minutos. Retóricamente, no se descarta que su competidor Microsoft pudiera sumarse a la iniciativa: sería una primicia con profundas implicaciones, pero hay motivos para dudar de este sobrevenido espíritu de colaboración entre competidores de esa talla.

Thomas Kurian, director ejecutivo de Google Cloud, ha dicho en entrevistas recientes que el mérito de su estrategia reside en contar con oferta propia “en todas las capas tecnológicas: energía [curioso que la mencione en primer lugar], chips, infraestructura, modelos, herramientas y aplicaciones”.